-

航瑞智能助力維尚家具打造自動倉儲系統(tǒng),,實(shí)現(xiàn)成品物流智能化升級

-

航瑞智能:準(zhǔn)確把握倉儲痛點(diǎn),,打造多樣化智能倉儲方案

-

高度集成化自動化立體倉庫:開啟高效物流新時(shí)代_航瑞智能

-

探秘倉儲物流中心:輸送機(jī)與RGV打造高效智能物流體系

-

共享裝備攜手航瑞智能打造砂芯智能倉儲,實(shí)現(xiàn)倉儲物流智能化升級

-

桁架機(jī)械手與輸送機(jī):打造高效智能流水線

-

?采用WMS倉庫管理系統(tǒng)能夠給企業(yè)帶來哪些好處,?

-

?航瑞智能:精細(xì)把握倉儲痛點(diǎn),,打造多樣化智能倉儲方案

-

往復(fù)式提升機(jī):垂直輸送系統(tǒng)的智能化解決方案

-

航瑞智能:準(zhǔn)確把握倉儲痛點(diǎn),打造多樣化智能倉儲方案

russiaH100GPU庫存

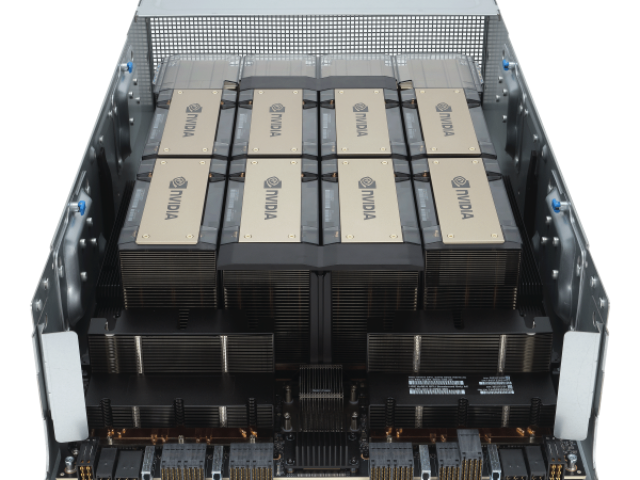

基于H100的系統(tǒng)和板卡H100SXM5GPU使用NVIDIA定制的SXM5板卡內(nèi)置H100GPU和HMB3內(nèi)存堆棧提供第四代NVLink和PCIeGen5連接提供高的應(yīng)用性能這種配置非常適合在一個(gè)服務(wù)器和跨服務(wù)器的情況下將應(yīng)用程序擴(kuò)展到多個(gè)GPU上的客戶,,通過在HGXH100服務(wù)器板卡上配置4-GPU和8-GPU實(shí)現(xiàn)4-GPU配置:包括GPU之間的點(diǎn)對點(diǎn)NVLink連接,,并在服務(wù)器中提供更高的CPU-GPU比率;8-GPU配置:包括NVSwitch,,以提供SHARP在網(wǎng)絡(luò)中的縮減和任意對GPU之間900GB/s的完整NVLink帶寬,。H100SXM5GPU還被用于功能強(qiáng)大的新型DGXH100服務(wù)器和DGXSuperPOD系統(tǒng)中。H100PCIeGen5GPU以有350W的熱設(shè)計(jì)功耗(ThermalDesignPower,TDP),,提供了H100SXM5GPU的全部能力該配置可選擇性地使用NVLink橋以600GB/s的帶寬連接多達(dá)兩個(gè)GPU,,接近PCIeGen5的5倍。H100PCIe非常適合主流加速服務(wù)器(使用標(biāo)準(zhǔn)的架構(gòu),,提供更低服務(wù)器功耗),,為同時(shí)擴(kuò)展到1或2個(gè)GPU的應(yīng)用提供了很好的性能,包括AIInference和一些HPC應(yīng)用,。在10個(gè)前列數(shù)據(jù)分析,、AI和HPC應(yīng)用程序的數(shù)據(jù)集中,單個(gè)H100PCIeGPU**地提供了H100SXM5GPU的65%的交付性能,,同時(shí)消耗了50%的功耗,。DGXH100andDGXSuperPODNVIDIADGXH100是一個(gè)通用的高性能人工智能系統(tǒng)。H100 GPU 優(yōu)惠促銷,,數(shù)量有限,。russiaH100GPU庫存

在游戲開發(fā)領(lǐng)域,H100 GPU 提供了強(qiáng)大的圖形處理能力和計(jì)算性能,。它能夠?qū)崿F(xiàn)更加復(fù)雜和逼真的游戲畫面,,提高游戲的視覺效果和玩家體驗(yàn)。H100 GPU 的并行處理單元可以高效處理大量圖形和物理運(yùn)算,減少延遲和卡頓現(xiàn)象,。對于開發(fā)者來說,,H100 GPU 的穩(wěn)定性和高能效為長時(shí)間的開發(fā)和測試提供了可靠保障,助力開發(fā)者創(chuàng)造出更具創(chuàng)意和吸引力的游戲作品,。當(dāng)前,,H100 GPU 的市場價(jià)格主要受到供需關(guān)系和生產(chǎn)成本的影響。由于 H100 GPU 在高性能計(jì)算中的表現(xiàn),,市場需求不斷增加,,推動了價(jià)格的上升。此外,,全球芯片短缺和供應(yīng)鏈問題也對 H100 GPU 的價(jià)格產(chǎn)生了重要影響,,導(dǎo)致其市場價(jià)格居高不下。盡管如此,,隨著市場供需關(guān)系的逐步平衡和供應(yīng)鏈的恢復(fù),,預(yù)計(jì) H100 GPU 的價(jià)格將逐漸趨于合理。對于計(jì)劃采購 H100 GPU 的企業(yè)和研究機(jī)構(gòu)來說,,關(guān)注市場價(jià)格動態(tài)和供應(yīng)鏈狀況,,有助于制定更加科學(xué)的采購決策。廣東H100GPU庫存H100 GPU 具備高效的數(shù)據(jù)傳輸能力,。

可以在多個(gè)計(jì)算節(jié)點(diǎn)上實(shí)現(xiàn)多達(dá)256個(gè)GPU之間的GPU-to-GPU通信,。與常規(guī)的NVLink(所有GPU共享一個(gè)共同的地址空間,請求直接使用GPU的物理地址進(jìn)行路由)不同,,NVLink網(wǎng)絡(luò)引入了一個(gè)新的網(wǎng)絡(luò)地址空間,由H100中新的地址轉(zhuǎn)換硬件支持,,以隔離所有GPU的地址空間和網(wǎng)絡(luò)地址空間,。這使得NVLink網(wǎng)絡(luò)可以安全地?cái)U(kuò)展到更多的GPU上。由于NVLink網(wǎng)絡(luò)端點(diǎn)不共享一個(gè)公共的內(nèi)存地址空間,,NVLink網(wǎng)絡(luò)連接在整個(gè)系統(tǒng)中并不是自動建立的,。相反,與其他網(wǎng)絡(luò)接口(如IB交換機(jī))類似,,用戶軟件應(yīng)根據(jù)需要顯式地建立端點(diǎn)之間的連接,。第三代NVSwitch包括駐留在節(jié)點(diǎn)內(nèi)部和外部的交換機(jī),用于連接服務(wù)器,、集群和數(shù)據(jù)中心環(huán)境中的多個(gè)GPU,。節(jié)點(diǎn)內(nèi)部每一個(gè)新的第三代NVSwitch提供64個(gè)端口。NVLinklinks交換機(jī)的總吞吐率從上一代的Tbits/sec提高到Tbits/sec,。還通過多播和NVIDIASHARP網(wǎng)內(nèi)精簡提供了集群操作的硬件加速,。加速集群操作包括寫廣播(all_gather)、reduce_scatter,、廣播原子,。組內(nèi)多播和縮減能提供2倍的吞吐量增益,,同時(shí)降低了小塊大小的延遲。集群的NVSwitch加速降低了用于集群通信的SM的負(fù)載,。新的NVLink交換系統(tǒng)新的NVLINK網(wǎng)絡(luò)技術(shù)和新的第三代NVSwitch相結(jié)合,。

H100 GPU 是英偉達(dá)推出的一款高性能圖形處理器,旨在滿足當(dāng)今數(shù)據(jù)密集型計(jì)算任務(wù)的需求,。它采用新的架構(gòu),,具備強(qiáng)大的計(jì)算能力和能效比,能夠提升各種計(jì)算任務(wù)的效率和速度,。無論是在人工智能,、科學(xué)計(jì)算還是大數(shù)據(jù)分析領(lǐng)域,H100 GPU 都能提供良好的性能和可靠性,。其并行處理能力和高帶寬內(nèi)存確保了復(fù)雜任務(wù)的順利進(jìn)行,,是各類高性能計(jì)算應(yīng)用的良好選擇。H100 GPU 擁有先進(jìn)的散熱設(shè)計(jì),,確保其在長時(shí)間高負(fù)荷運(yùn)行時(shí)依然能夠保持穩(wěn)定和高效,。對于需要長時(shí)間運(yùn)行的大規(guī)模計(jì)算任務(wù)來說,H100 GPU 的可靠性和穩(wěn)定性尤為重要,。它的設(shè)計(jì)不僅考慮了性能,,還兼顧了散熱和能效,使其在保持高性能的同時(shí),,依然能夠節(jié)省能源成本,。無論是企業(yè)級應(yīng)用還是科學(xué)研究,H100 GPU 都能夠?yàn)橛脩籼峁┏掷m(xù)的高性能支持,。H100 GPU 在云計(jì)算中的應(yīng)用也非常多,。

它可能每年產(chǎn)生$500mm++的經(jīng)常性收入。ChatGPT運(yùn)行在GPT-4和API上,。GPT-4和API需要GPU才能運(yùn)行,。很多。OpenAI希望為ChatGPT及其API發(fā)布更多功能,,但他們不能,,因?yàn)樗麄儫o法訪問足夠的GPU。他們通過Microsoft/Azure購買了很多NvidiaGPU,。具體來說,,他們想要的GPU是NvidiaH100GPU。為了制造H100SXMGPU,,Nvidia使用臺積電進(jìn)行制造,,并使用臺積電的CoWoS封裝技術(shù),并使用主要來自SK海力士的HBM3。OpenAI并不是***一家想要GPU的公司(但他們是產(chǎn)品市場契合度強(qiáng)的公司),。其他公司也希望訓(xùn)練大型AI模型,。其中一些用例是有意義的,但有些用例更多的是驅(qū)動的,,不太可能使產(chǎn)品與市場契合,。這推高了需求。此外,,一些公司擔(dān)心將來無法訪問GPU,,因此即使他們還不需要它們,他們現(xiàn)在也會下訂單,。因此,,“對供應(yīng)短缺的預(yù)期會造成更多的供應(yīng)短缺”正在發(fā)生。GPU需求的另一個(gè)主要貢獻(xiàn)者來自想要?jiǎng)?chuàng)建新的LLM的公司,。以下是關(guān)于想要構(gòu)建新LLM的公司對GPU需求的故事:公司高管或創(chuàng)始人知道人工智能領(lǐng)域有很大的機(jī)會,。也許他們是一家想要在自己的數(shù)據(jù)上訓(xùn)練LLM并在外部使用它或出售訪問權(quán)限的企業(yè),或者他們是一家想要構(gòu)建LLM并出售訪問權(quán)限的初創(chuàng)公司,。他們知道他們需要GPU來訓(xùn)練大型模型,。能夠?qū)崿F(xiàn)更加復(fù)雜和逼真的游戲畫面。天津H100GPU一臺多少錢

H100 GPU 提供高效的數(shù)據(jù)分析能力,。russiaH100GPU庫存

他們與來自大云(Azure,,GoogleCloud,AWS)的一些人交談,,試圖獲得許多H100,。他們發(fā)現(xiàn)他們無法從大云中獲得大量分配,并且一些大云沒有良好的網(wǎng)絡(luò)設(shè)置,。因此,,他們與其他提供商(如CoreWeave,Oracle,,Lambda,F(xiàn)luidStack)進(jìn)行了交談,。如果他們想自己購買GPU并擁有它們,,也許他們也會與OEM和Nvidia交談。終,,他們獲得了大量的GPU?,F(xiàn)在,他們試圖獲得產(chǎn)品市場契合度,。如果不是很明顯,,這條途徑就沒有那么好了-請記住,OpenAI在更小的模型上獲得了產(chǎn)品市場契合度,然后將它們擴(kuò)大了規(guī)模,。但是,,現(xiàn)在要獲得產(chǎn)品市場契合度,您必須比OpenAI的模型更適合用戶的用例,,因此首先,,您將需要比OpenAI開始時(shí)更多的GPU。預(yù)計(jì)至少到100年底,,H2023將短缺數(shù)百或數(shù)千次部署,。到2023年底,情況將更加清晰,,但就目前而言,,短缺似乎也可能持續(xù)到2024年的某些時(shí)間。GPU供需之旅,。大版本取得聯(lián)系#作者:克萊·帕斯卡,。問題和筆記可以通過電子郵件發(fā)送。新帖子:通過電子郵件接收有關(guān)新帖子的通知,。幫助:看這里,。自然的下一個(gè)問題-英偉達(dá)替代品呢?#自然的下一個(gè)問題是“好吧,,競爭和替代方案呢,?我正在探索硬件替代方案以及軟件方法。提交我應(yīng)該探索的東西作為此表格的替代方案,。例如,。russiaH100GPU庫存

- N9K-C93180-FX3-B8C 折扣 2025-06-04

- N9K-C9300-ACK 供應(yīng)商 2025-06-03

- N9K-C93180-FX-B24C distributor 2025-06-03

- N9K-C9500-P-CV datasheet 2025-06-03

- 2960X-24PD-L交換機(jī)價(jià)格 2025-06-03

- N9K-C93108TC-FX-24 總代 2025-06-03

- 上海2960X-24TS-L交換機(jī)端口 2025-06-03

- C9300L-48P-4X-E交換機(jī)Cisco 2025-06-03

- C9200-48T-E交換機(jī)產(chǎn)品價(jià)格 2025-06-02

- 肇慶9200L交換機(jī)代理商 2025-06-02

- 吉林便攜式時(shí)頻綜合測試儀 2025-06-04

- kelk傳感器 2025-06-04

- 廣東無限流量卡推薦 2025-06-04

- 上海BLE5.0藍(lán)牙模組生產(chǎn)廠家 2025-06-04

- 山東衛(wèi)星北斗應(yīng)急救援頭盔B3北斗終端 2025-06-04

- 清遠(yuǎn)質(zhì)量通訊設(shè)備銷售推薦貨源 2025-06-04

- 黃浦區(qū)智能化增強(qiáng)型無線通信設(shè)備直銷價(jià) 2025-06-04

- 嘉定區(qū)附近輕便型無線通信設(shè)備廠家現(xiàn)貨 2025-06-04

- 調(diào)制器芯片工藝 2025-06-04

- 河源質(zhì)量新型膜材料銷售供應(yīng) 2025-06-04