QatarH100GPU多少錢

H100 GPU 支持新的 PCIe 4.0 接口,,提供了更高的數(shù)據(jù)傳輸速度和帶寬,與前代 PCIe 3.0 相比,,帶寬提升了兩倍,。這使得 H100 GPU 在與主機系統(tǒng)通信時能夠更快速地交換數(shù)據(jù),減少了 I/O 瓶頸,,進一步提升了整體系統(tǒng)性能,。PCIe 4.0 的支持使得 H100 GPU 能夠與現(xiàn)代主流服務器和工作站更好地兼容,充分發(fā)揮其高性能計算能力,。H100 GPU 也采用了多項創(chuàng)新技術,。其采用了先進的風冷和液冷混合散熱設計,能夠在高負載運行時保持穩(wěn)定的溫度,,確保 GPU 的長期穩(wěn)定運行H100 GPU 提供高效的功耗管理。QatarH100GPU多少錢

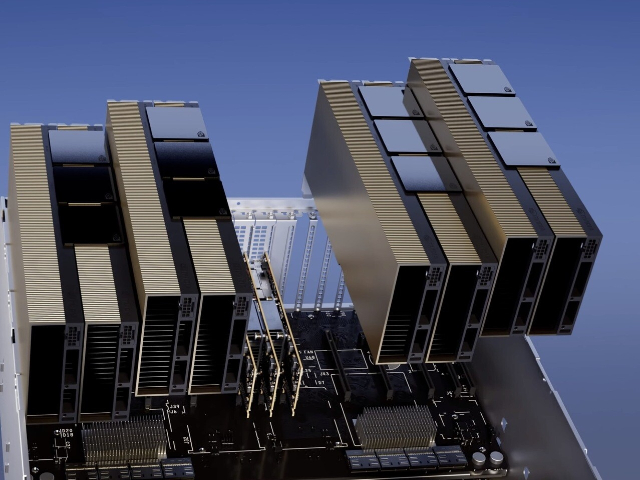

第四代NVIDIANVLink在全歸約操作上提供了3倍的帶寬提升,,在7倍PCIeGen5帶寬下,,為多GPUIO提供了900GB/sec的總帶寬,,比上一代NVLink增加了50%的總帶寬。第三代NVSwitch技術包括駐留在節(jié)點內(nèi)部和外部的交換機,,用于連接服務器,、集群和數(shù)據(jù)中心環(huán)境中的多個GPU。節(jié)點內(nèi)部的每個NVSwitch提供64個第四代NVLink鏈路端口,,以加速多GPU連接,。交換機的總吞吐率從上一代的。新的第三代NVSwitch技術也為多播和NVIDIASHARP網(wǎng)絡內(nèi)精簡的集群操作提供了硬件加速,。新的NVLinkSwitch系統(tǒng)互連技術和新的基于第三代NVSwitch技術的第二級NVLink交換機引入地址空間隔離和保護,,使得多達32個節(jié)點或256個GPU可以通過NVLink以2:1的錐形胖樹拓撲連接。這些相連的節(jié)點能夠提供TB/sec的全連接帶寬,,并且能夠提供難以置信的一個exaFlop(百億億次浮點運算)的FP8稀疏AI計算,。PCIeGen5提供了128GB/sec的總帶寬(各個方向上為64GB/s),,而Gen4PCIe提供了64GB/sec的總帶寬(各個方向上為32GB/sec),。PCIeGen5使H100可以與性能高的x86CPU和SmartNICs/DPU(數(shù)據(jù)處理單元)接口。DubaiHPEH100GPUH100 GPU 在云計算中的應用也非常多,。

英偉達可以純粹提高價格以找到清算價格,,并且在某種程度上正在這樣做,。但重要的是要知道,,終H100的分配取決于Nvidia更喜歡將分配分配給誰,。供應H100顯卡#造成瓶頸的原因-供應生產(chǎn)方面的瓶頸是什么,?哪些組件?誰生產(chǎn)它們,?誰制造了H100,?#臺積電,。英偉達可以使用其他芯片廠進行H100生產(chǎn)嗎,?#不是真的,,至少現(xiàn)在還沒有。他們過去曾與三星合作過,。但在H100和其他5nmGPU上,,他們只使用臺積電。這意味著三星還不能滿足他們對前列GPU的需求,。他們將來可能會與英特爾合作,,并再次與三星合作,但這些都不會在短期內(nèi)以有助于H100供應緊縮的方式發(fā)生,。不同的臺積電節(jié)點如何關聯(lián),?#臺積電5nm系列:N5264N要么適合作為N5的增強版本,,要么低于N5PN5P4N要么適合作為N5P的增強版本,要么低于N5作為N5的增強版本N4N4PH100是在哪個臺積電節(jié)點上制造的,?#臺積電4N,。這是Nvidia的一個特殊節(jié)點,它屬于5nm系列,,并且是增強的5nm,,而不是真正的4nm,。還有誰使用該節(jié)點,?#是蘋果,,但他們主要轉(zhuǎn)向N3,并保留了大部分N3容量,。高通和AMD是N5家族的其他大客戶,。A100使用哪個臺積電節(jié)點?#N727晶圓廠產(chǎn)能通常提前多久預留,?#不確定,,雖然可能是12+個月。

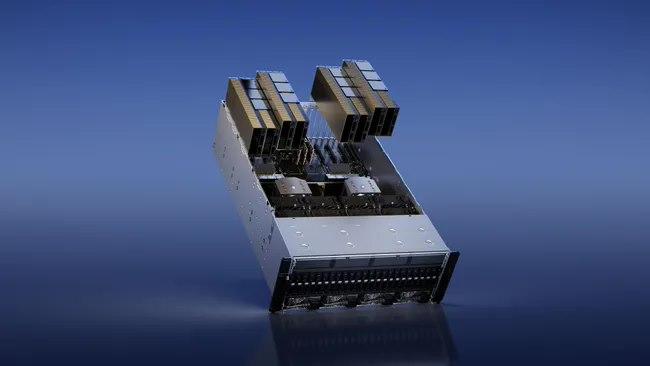

利用 NVIDIA H100 Tensor GPU,,提供所有工作負載前所未有的效能,、可擴展性和安全性。 使用 NVIDIA® NVLink® Switch 系統(tǒng),,比較高可連接 256 個 H100 來加速百萬兆級工作負載,,此外還有的 Transformer Engine,可解決一兆參數(shù)語言模型,。 H100 所結合的技術創(chuàng)新,可加速大型語言模型速度,,比前一代快上 30 倍,提供業(yè)界的對話式人工智能,。英偉達 DGX SuperPOD架構采用英偉達的NVLink和NVSwitch系統(tǒng),多可連接32個DGX節(jié)點,,共256個H100 GPU。這是一個真正的人工智能基礎設施平臺,;英偉達的DGX SuperPOD數(shù)據(jù)中心設計[4]讓我們對真正的企業(yè)人工智能基礎設施的巨大功率和冷卻需求有了一些了解。H100 GPU 支持 NVIDIA NVLink 技術,。

以優(yōu)化內(nèi)存和緩存的使用和性能,。H100HBM3和HBM2eDRAM子系統(tǒng)帶寬性能H100L2cache采用分區(qū)耦合結構(partitionedcrossbarstructure)對與分區(qū)直接相連的GPC中的子模塊的訪存數(shù)據(jù)進行定位和高速緩存,。L2cache駐留控制優(yōu)化了容量利用率,,允許程序員有選擇地管理應該保留在緩存中或被驅(qū)逐的數(shù)據(jù),。內(nèi)存子系統(tǒng)RAS特征RAS:Reliability,Av**lable,Serviceability(可靠性,,可獲得性)ECC存儲彈性(MemoryResiliency)H100HBM3/2e存儲子系統(tǒng)支持單糾錯雙檢錯(SECDED)糾錯碼(ECC)來保護數(shù)據(jù)。H100的HBM3/2e存儲器支持"邊帶ECC",,其中一個與主HBM存儲器分開的小的存儲區(qū)域用于ECC位內(nèi)存行重映射H100HBM3/HBM2e子系統(tǒng)可以將產(chǎn)生錯誤ECC碼的內(nèi)存單元置為失效。并使用行重映射邏輯將其在啟動時替換為保留的已知正確的行每個HBM3/HBM2e內(nèi)存塊中的若干內(nèi)存行被預留為備用行,,當需要替換被判定為壞的行時可以被,。第二代安全MIGMIG技術允許將GPU劃分為多達7個GPU事件(instance),,以優(yōu)化GPU利用率,,并在不同客戶端(例如VM,、容器和進程等)之間提供一個被定義的QoS和隔離,在為客戶端提供增強的安全性和保證GPU利用率之外,,還確保一個客戶端不受其他客戶端的工作和調(diào)度的影響,。H100 GPU 提供高效的計算資源利用率,。QatarH100GPU多少錢

H100 GPU 限時降價,,數(shù)量有限。QatarH100GPU多少錢

用于訓練,、推理和分析,。配置了Bluefield-3,NDRInfiniBand和第二代MIG技術單個DGXH100系統(tǒng)提供了16petaFLOPS(千萬億次浮點運算)(FP16稀疏AI計算性能),。通過將多個DGXH100系統(tǒng)連接組成集群(稱為DGXPODs或DGXSuperPODs),,可以很容易地擴大這種性能,。DGXSuperPOD從32個DGXH100系統(tǒng)開始,被稱為"可擴展單元"集成了256個H100GPU,這些GPU通過基于第三代NVSwitch技術的新的二級NVLink交換機連接,,提供了1exaFLOP的FP8稀疏AI計算性能,。同時支持無線帶寬(InifiniBand,IB)和NVLINKSwitch網(wǎng)絡選項,。HGXH100通過NVLink和NVSwitch提供的高速互連,HGXH100將多個H100結合起來,,使其能創(chuàng)建世界上強大的可擴展服務器,。HGXH100可作為服務器構建模塊,,以集成底板的形式在4個或8個H100GPU配置中使用,。H100CNXConvergedAcceleratorNVIDIAH100CNX將NVIDIAH100GPU的強大功能與NVIDIA?ConnectX-7SmartNIC的**組網(wǎng)能力相結合,可提供高達400Gb/s的帶寬包括NVIDIAASAP2(加速交換和分組處理)等創(chuàng)新功能,以及用于TLS/IPsec/MACsec加密/的在線硬件加速。這種獨特的架構為GPU驅(qū)動的I/O密集型工作負載提供了前所未有的性能,,如在企業(yè)數(shù)據(jù)中心進行分布式AI訓練,或在邊緣進行5G信號處理等,。QatarH100GPU多少錢

- C1000-8P-2G交換機優(yōu)惠 2025-05-30

- C1000-48P-4X交換機廠家 2025-05-30

- 北京2960X-24PS-L交換機價格 2025-05-30

- 2960X-48FPS-L交換機電源 2025-05-30

- 廣州2960X-48PS-L交換機停產(chǎn) 2025-05-30

- C9200-24T-E交換機Cisco 2025-05-30

- 北京2960X-24PS-L交換機Datasheet 2025-05-30

- 深圳Cisco交換機端口 2025-05-30

- 珠海2960X交換機端口 2025-05-29

- 北京9200L交換機技術支持 2025-05-29

- 肇慶比較好的新型膜材料銷售規(guī)格尺寸 2025-06-01

- 日照智能能耗管理系統(tǒng)服務 2025-06-01

- 安徽電力物聯(lián)網(wǎng)平臺 2025-06-01

- 江門信息化至盛ACM3129A 2025-06-01

- 廣東質(zhì)量多合一5G融合終端聯(lián)系人 2025-06-01

- 徐匯區(qū)本地無線路由器推薦貨源 2025-06-01

- 廣東附近新型膜材料銷售規(guī)格尺寸 2025-06-01

- 專業(yè)井下作業(yè)票防爆手機定制廠家 2025-06-01

- 陽江頭盔骨傳導振子市場需求 2025-06-01

- 生活繳費賣家支付寶紅包優(yōu)惠指南 2025-06-01