NVLINKH100GPU代理商

我理解的就是這些等待的線程在等待的時候無法執(zhí)行其他工作)也是一個分裂的屏障,,但不對到達(dá)的線程計數(shù),同時也對事務(wù)進(jìn)行計數(shù)。為寫入共享內(nèi)存引入一個新的命令,,同時傳遞要寫入的數(shù)據(jù)和事務(wù)計數(shù),。事務(wù)計數(shù)本質(zhì)上是對字節(jié)計數(shù)異步事務(wù)屏障會在W**t命令處阻塞線程,直到所有生產(chǎn)者線程都執(zhí)行了一個Arrive,,所有事務(wù)計數(shù)之和達(dá)到期望值,。異步事務(wù)屏障是異步內(nèi)存拷貝或數(shù)據(jù)交換的一種強(qiáng)有力的新原語。集群可以進(jìn)行線程塊到線程塊通信,,進(jìn)行隱含同步的數(shù)據(jù)交換,,集群能力建立在異步事務(wù)屏障之上。H100HBM和L2cache內(nèi)存架構(gòu)HBM存儲器由內(nèi)存堆棧組成,,位于與GPU相同的物理封裝上,,與傳統(tǒng)的GDDR5/6內(nèi)存相比,提供了可觀的功耗和面積節(jié)省,,允許更多的GPU被安裝在系統(tǒng)中,。devicememory:駐留在HBM內(nèi)存空間的CUDA程序訪問的全局和局部內(nèi)存區(qū)域constantcache:駐留在devicememory內(nèi)的不變內(nèi)存空間texturecache:駐留在devicememory內(nèi)的紋理和表面內(nèi)存空間L2cache:對HBM內(nèi)存進(jìn)行讀和寫servicesmemory請求來源于GPU內(nèi)的各種子系統(tǒng)HBM和L2內(nèi)存空間對所有SM和所有運行在GPU上的應(yīng)用程序都是可訪問的。HBM3或HBM2eDRAM和L2緩存子系統(tǒng)都支持?jǐn)?shù)據(jù)壓縮和解壓縮技術(shù),。H100 GPU 提供高效的數(shù)據(jù)分析能力,。NVLINKH100GPU代理商

使用TSMC4nm工藝定制800億個晶體管,814mm2芯片面積,。NVIDIAGraceHopperSuperchipCPU+GPU架構(gòu)NVIDIAGraceCPU:利用ARM架構(gòu)的靈活性,,創(chuàng)建了從底層設(shè)計的CPU和服務(wù)器架構(gòu),用于加速計算,。H100:通過NVIDIA的超高速片間互連與Grace配對,,能提供900GB/s的帶寬,比PCIeGen5快了7倍目錄H100GPU主要特征基于H100的系統(tǒng)和板卡H100張量架構(gòu)FP8數(shù)據(jù)格式用于加速動態(tài)規(guī)劃(“DynamicProgramming”)的DPX指令L1數(shù)據(jù)cache和共享內(nèi)存結(jié)合H100GPU層次結(jié)構(gòu)和異步性改進(jìn)線程塊集群(ThreadBlockClusters)分布式共享內(nèi)存(DSMEM)異步執(zhí)行H100HBM和L2cache內(nèi)存架構(gòu)H100HBM3和HBM2eDRAM子系統(tǒng)H100L2cache內(nèi)存子系統(tǒng)RAS特征第二代安全MIGTransformer引擎第四代NVLink和NVLink網(wǎng)絡(luò)第三代NVSwitch新的NVLink交換系統(tǒng)PCIeGen5安全性增強(qiáng)和保密計算H100video/IO特征H100GPU主要特征新的流式多處理器(StreamingMultiprocessor,SM)第四代張量:片間通信速率提高了6倍(包括單個SM加速,、額外的SM數(shù)量,、更高的時鐘);在等效數(shù)據(jù)類型上提供了2倍的矩陣乘加,。MatrixMultiply-Accumulate,MMA)計算速率,,相比于之前的16位浮點運算,,使用新的FP8數(shù)據(jù)類型使速率提高了4倍,。NVLINKH100GPU代理商H100 GPU 提供 312 TFLOPS 的 Tensor Core 性能。

視頻編輯需要處理大量的圖像和視頻數(shù)據(jù),H100 GPU 的強(qiáng)大計算能力為此類任務(wù)提供了極大的便利,。其高帶寬內(nèi)存和并行處理能力能夠快速渲染和編輯高分辨率視頻,,提升工作效率。無論是實時預(yù)覽,、處理還是多層次剪輯,,H100 GPU 都能流暢應(yīng)對,減少卡頓和渲染時間,。其高能效設(shè)計和穩(wěn)定性確保了視頻編輯過程的順利進(jìn)行,使其成為視頻編輯領(lǐng)域的理想選擇,。H100 GPU 的并行處理能力和高帶寬內(nèi)存確保了復(fù)雜任務(wù)的順利進(jìn)行。其在視頻編輯中的應(yīng)用不僅提升了工作效率,,還顯著提高了視頻質(zhì)量,,使得創(chuàng)意工作更加輕松和高效,。

他們與來自大云(Azure,,GoogleCloud,AWS)的一些人交談,,試圖獲得許多H100。他們發(fā)現(xiàn)他們無法從大云中獲得大量分配,,并且一些大云沒有良好的網(wǎng)絡(luò)設(shè)置。因此,,他們與其他提供商(如CoreWeave,,Oracle,Lambda,,F(xiàn)luidStack)進(jìn)行了交談,。如果他們想自己購買GPU并擁有它們,,也許他們也會與OEM和Nvidia交談,。終,,他們獲得了大量的GPU。現(xiàn)在,,他們試圖獲得產(chǎn)品市場契合度,。如果不是很明顯,,這條途徑就沒有那么好了-請記住,OpenAI在更小的模型上獲得了產(chǎn)品市場契合度,,然后將它們擴(kuò)大了規(guī)模,。但是,,現(xiàn)在要獲得產(chǎn)品市場契合度,您必須比OpenAI的模型更適合用戶的用例,,因此首先,您將需要比OpenAI開始時更多的GPU,。預(yù)計至少到100年底,,H2023將短缺數(shù)百或數(shù)千次部署,。到2023年底,情況將更加清晰,但就目前而言,,短缺似乎也可能持續(xù)到2024年的某些時間。GPU供需之旅,。大版本取得聯(lián)系#作者:克萊·帕斯卡。問題和筆記可以通過電子郵件發(fā)送,。新帖子:通過電子郵件接收有關(guān)新帖子的通知,。幫助:看這里。自然的下一個問題-英偉達(dá)替代品呢,?#自然的下一個問題是“好吧,競爭和替代方案呢,?我正在探索硬件替代方案以及軟件方法,。提交我應(yīng)該探索的東西作為此表格的替代方案,。例如。H100 GPU 采用先進(jìn)的風(fēng)冷和液冷混合散熱設(shè)計,。

他們與英偉達(dá)合作托管了一個基于NVIDIA的集群。Nvidia也是Azure的客戶,。哪個大云擁有好的網(wǎng)絡(luò),?#Azure,,CoreWeave和Lambda都使用InfiniBand,。Oracle具有良好的網(wǎng)絡(luò),,它是3200Gbps,但它是以太網(wǎng)而不是InfiniBand,,對于高參數(shù)計數(shù)LLM訓(xùn)練等用例,,InfiniBand可能比IB慢15-20%左右,。AWS和GCP的網(wǎng)絡(luò)就沒有那么好了,。企業(yè)使用哪些大云?#在一個大約15家企業(yè)的私有數(shù)據(jù)點中,,所有15家都是AWS,,GCP或Azure,,零甲骨文。大多數(shù)企業(yè)將堅持使用現(xiàn)有的云,。絕望的初創(chuàng)公司會去哪里,哪里就有供應(yīng),。DGXCloud怎么樣,英偉達(dá)正在與誰合作,?#“NVIDIA正在與的云服務(wù)提供商合作托管DGX云基礎(chǔ)設(shè)施,,從Oracle云基礎(chǔ)設(shè)施(OCI)開始”-您處理Nvidia的銷售,,但您通過現(xiàn)有的云提供商租用它(首先使用Oracle啟動,,然后是Azure,,然后是GoogleCloud,,而不是使用AWS啟動)3233Jensen在上一次財報電話會議上表示:“理想的組合是10%的NvidiaDGX云和90%的CSP云,。大云什么時候推出他們的H100預(yù)覽,?#CoreWeave是個。34英偉達(dá)給了他們較早的分配,,大概是為了幫助加強(qiáng)大型云之間的競爭(因為英偉達(dá)是投資者),。Azure于13月100日宣布H<>可供預(yù)覽,。35甲骨文于21月100日宣布H<>數(shù)量有限。H100 GPU 限時特惠,,立刻搶購。NVLINKH100GPU代理商

H100 GPU 在游戲開發(fā)中提升視覺效果,。NVLINKH100GPU代理商

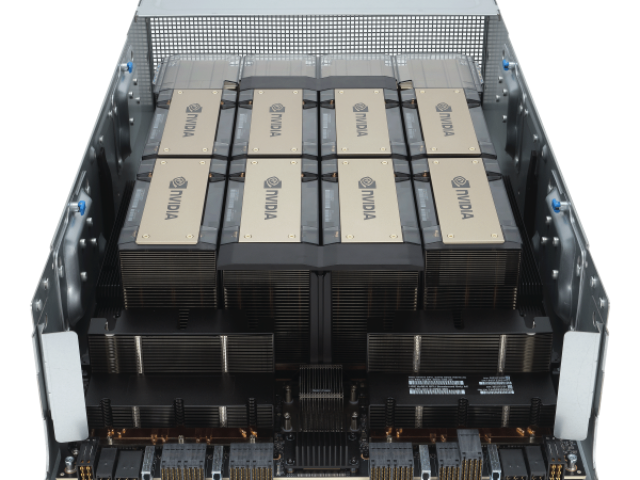

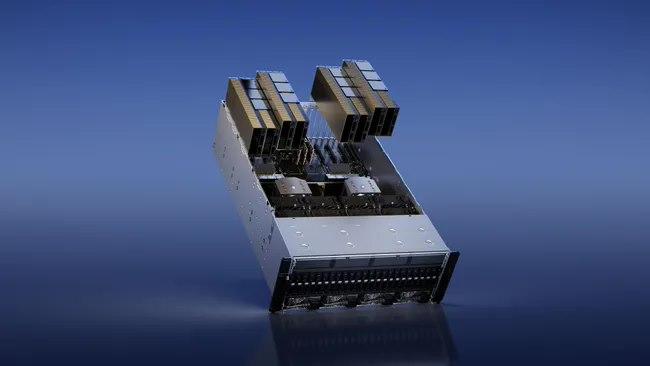

用于訓(xùn)練,、推理和分析,。配置了Bluefield-3,NDRInfiniBand和第二代MIG技術(shù)單個DGXH100系統(tǒng)提供了16petaFLOPS(千萬億次浮點運算)(FP16稀疏AI計算性能),。通過將多個DGXH100系統(tǒng)連接組成集群(稱為DGXPODs或DGXSuperPODs),,可以很容易地擴(kuò)大這種性能,。DGXSuperPOD從32個DGXH100系統(tǒng)開始,,被稱為"可擴(kuò)展單元"集成了256個H100GPU,,這些GPU通過基于第三代NVSwitch技術(shù)的新的二級NVLink交換機(jī)連接,提供了1exaFLOP的FP8稀疏AI計算性能,。同時支持無線帶寬(InifiniBand,IB)和NVLINKSwitch網(wǎng)絡(luò)選項,。HGXH100通過NVLink和NVSwitch提供的高速互連,,HGXH100將多個H100結(jié)合起來,,使其能創(chuàng)建世界上強(qiáng)大的可擴(kuò)展服務(wù)器。HGXH100可作為服務(wù)器構(gòu)建模塊,,以集成底板的形式在4個或8個H100GPU配置中使用,。H100CNXConvergedAcceleratorNVIDIAH100CNX將NVIDIAH100GPU的強(qiáng)大功能與NVIDIA?ConnectX-7SmartNIC的**組網(wǎng)能力相結(jié)合,,可提供高達(dá)400Gb/s的帶寬包括NVIDIAASAP2(加速交換和分組處理)等創(chuàng)新功能,,以及用于TLS/IPsec/MACsec加密/的在線硬件加速。這種獨特的架構(gòu)為GPU驅(qū)動的I/O密集型工作負(fù)載提供了前所未有的性能,,如在企業(yè)數(shù)據(jù)中心進(jìn)行分布式AI訓(xùn)練,,或在邊緣進(jìn)行5G信號處理等。NVLINKH100GPU代理商

- N9K-C9300-ACK 供應(yīng)商 2025-06-03

- 上海2960X-24TS-L交換機(jī)端口 2025-06-03

- C9200-48T-E交換機(jī)產(chǎn)品價格 2025-06-02

- 肇慶9200L交換機(jī)代理商 2025-06-02

- 北京2960X交換機(jī)貨期 2025-06-02

- 海南Cisco交換機(jī)List Price 2025-06-02

- C9200L-48P-4G-E交換機(jī)折扣 2025-06-02

- C1000-8P-2G交換機(jī)優(yōu)惠 2025-05-30

- C1000-48P-4X交換機(jī)廠家 2025-05-30

- 北京2960X-24PS-L交換機(jī)價格 2025-05-30

- 位移沉降機(jī)器視覺位移監(jiān)測儀硬件定制 2025-06-03

- 中山振子生產(chǎn)工藝 2025-06-03

- 青島智能化能耗管理系統(tǒng) 2025-06-03

- 廣東低功耗北斗應(yīng)急救援頭盔B3北斗模塊 2025-06-03

- 重慶工具設(shè)備管理系統(tǒng)開發(fā) 2025-06-03

- 深圳音視頻記錄儀代加工批發(fā)廠家 2025-06-03

- 內(nèi)蒙古實驗教學(xué)與管理實驗教學(xué)與實驗室信息管理平臺 2025-06-03

- ??陔娮酉嗫仃?yán)走_(dá)追蹤 2025-06-03

- 福建介損高壓套管在線監(jiān)測廠家電話 2025-06-03

- 成都無線藍(lán)牙模組功能 2025-06-03